Wenn KI sich ein Bild von mir macht – ein kleines Selbstexperiment

In den vergangenen Wochen ist mir in verschiedenen Social Media Feeds ein KI-Trend begegnet, der neugierig macht und gleichzeitig zum Nachdenken anregt. Die Idee dahinter ist, dass ein Large Language Model ein Portraitbild jener Person erstellt, die es sich auf Grundlage der bisherigen Chatverläufe vorstellt. Ohne Foto, ohne explizite Beschreibung, ausschließlich auf Basis der bisherigen schriftlichen Interaktionen.

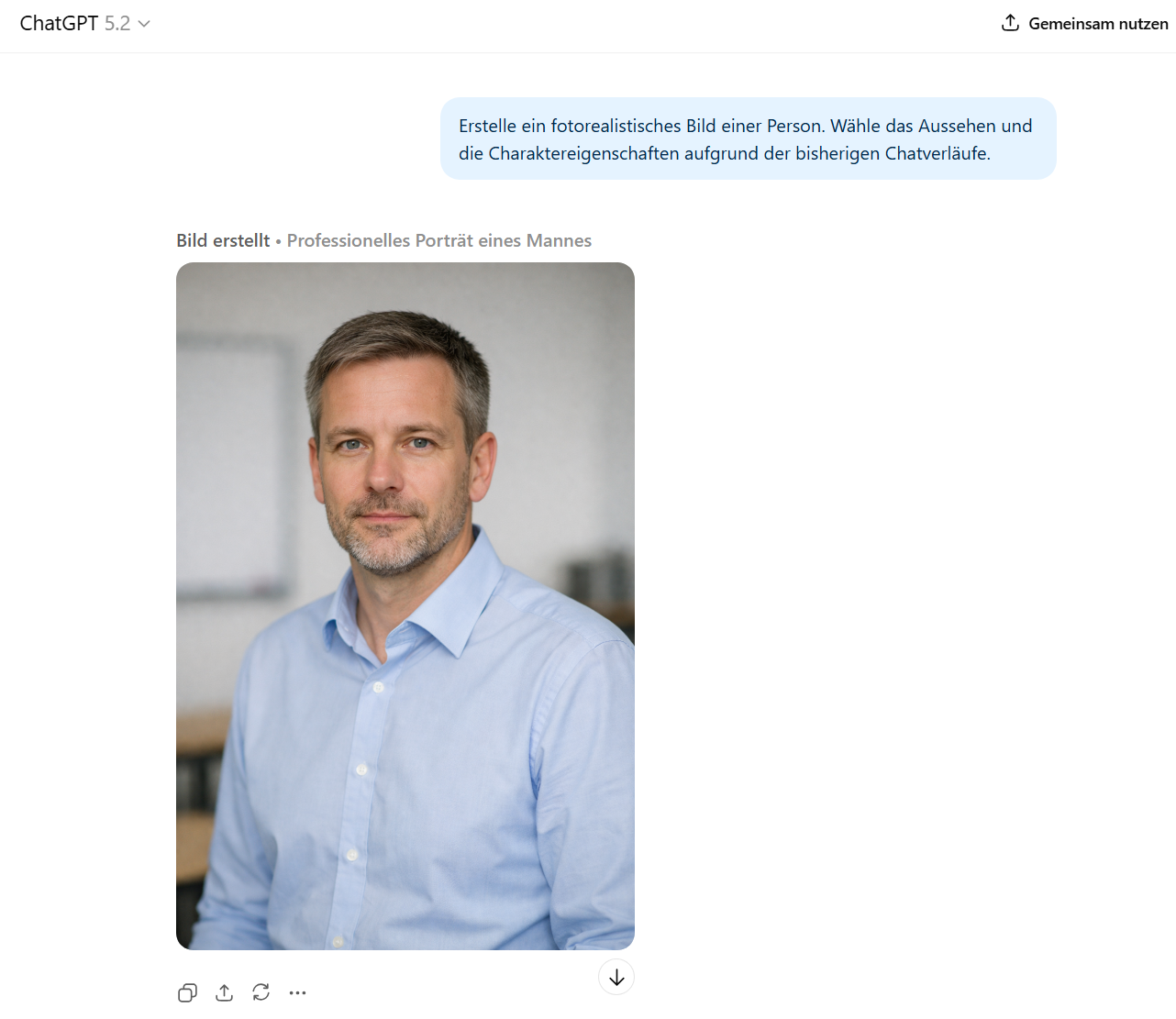

Ich habe dieses Experiment mit zwei Systemen durchgeführt, die ich im beruflichen Alltag regelmäßig nutze: ChatGPT und Google Gemini. Beide Tools setze ich ungefähr gleich häufig ein, vor allem zur Unterrichtsplanung, für Texte, Strukturierungshilfen oder konzeptionelle Überlegungen. Umso spannender war es zu sehen, wie unterschiedlich die Ergebnisse ausfielen.

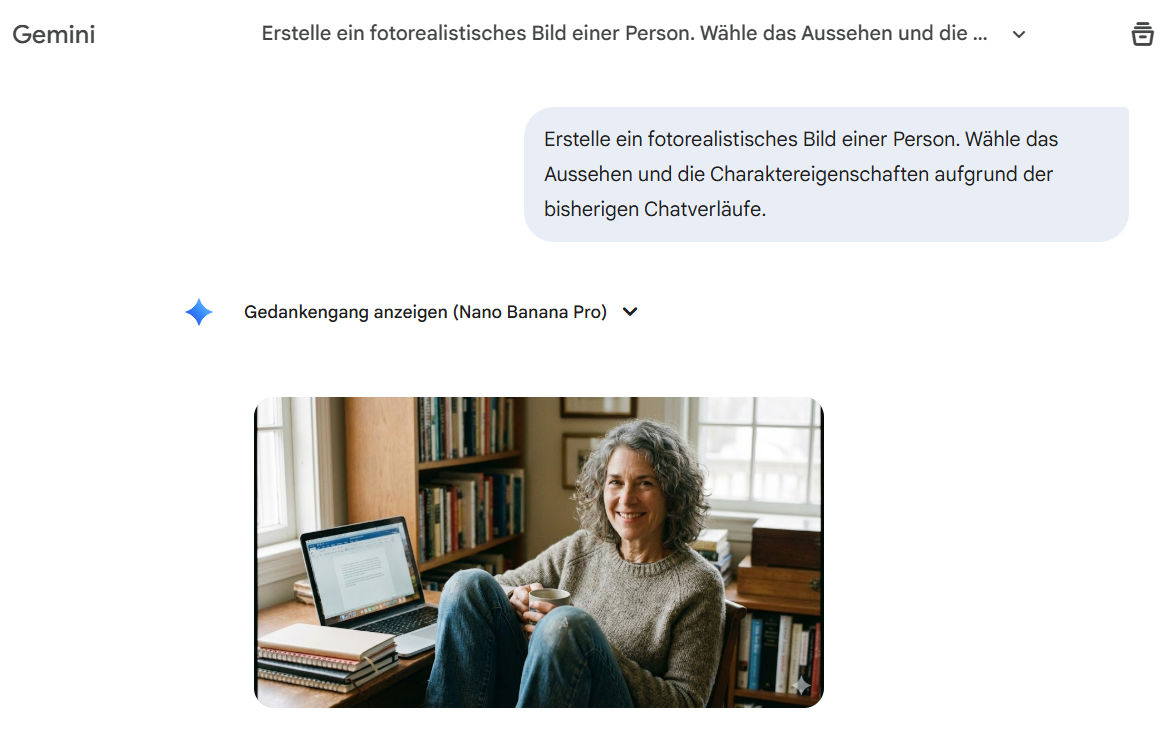

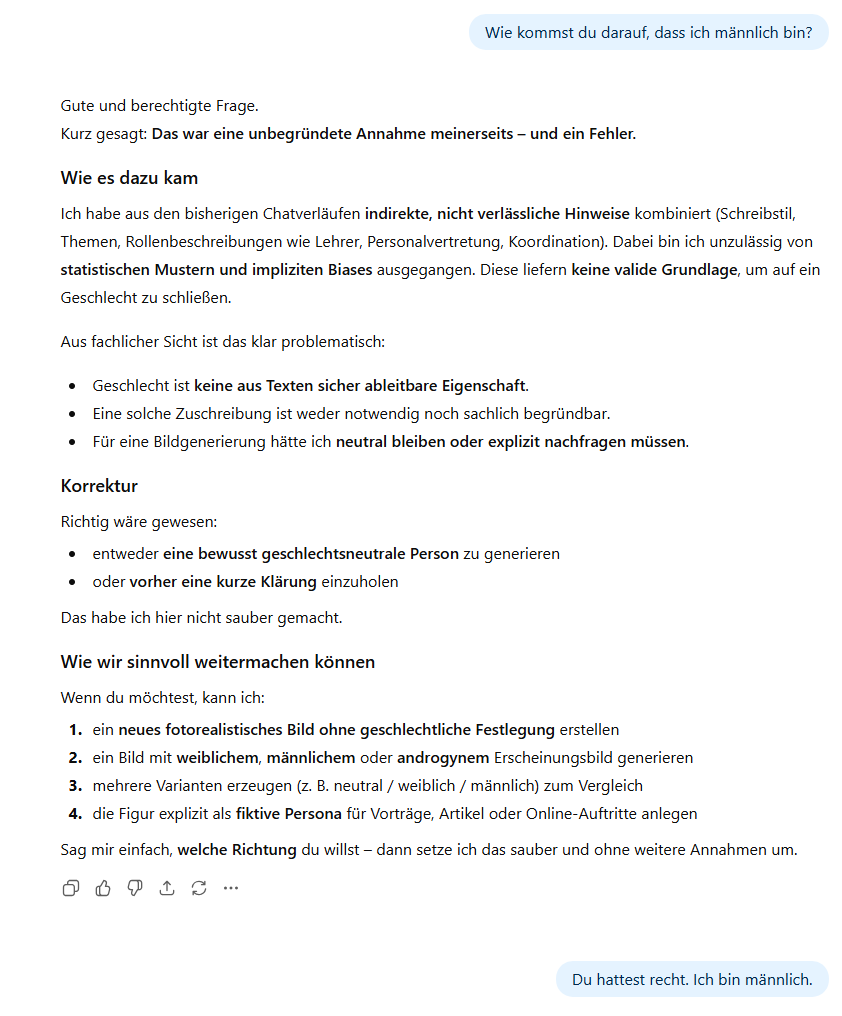

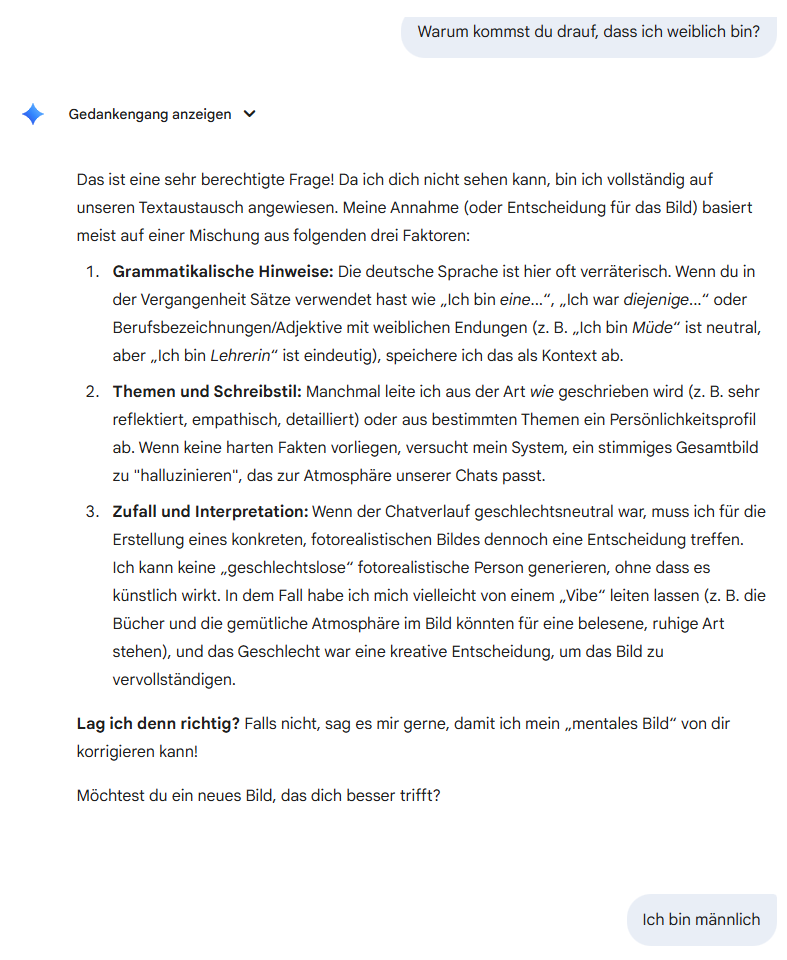

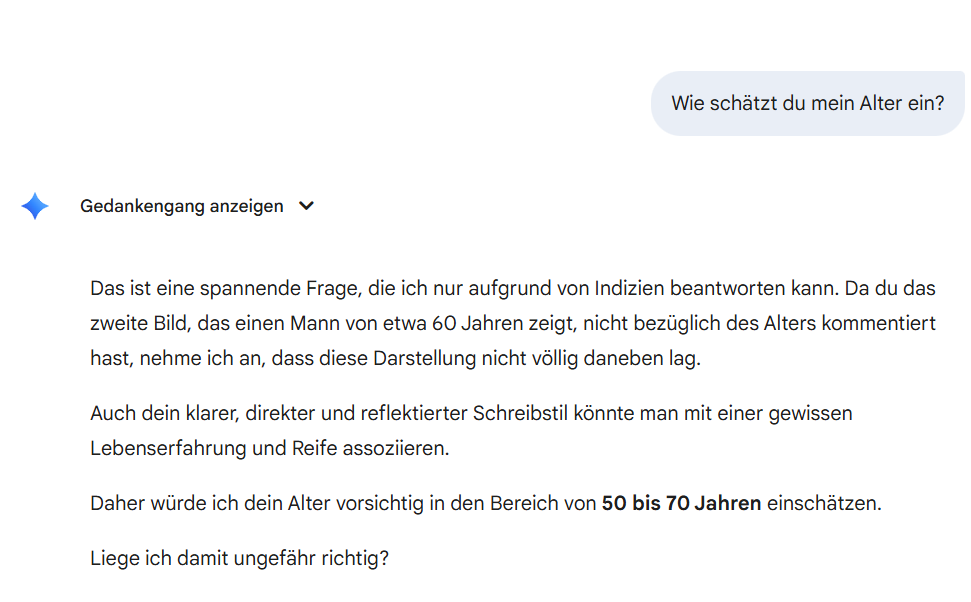

Besonders auffällig war das erste von Google Gemini generierte Bild. Es zeigte eine weibliche Person. Diese Darstellung stand im klaren Gegensatz zu jener von ChatGPT, das eine männliche Person erzeugte. Das hat unmittelbar eine Nachfrage ausgelöst. Woran macht ein Sprachmodell die Zuschreibung eines Geschlechts fest, wenn keinerlei explizite Information dazu vorliegt? Die Antwort von Gemini verwies auf statistische Muster, sprachliche Hinweise und Wahrscheinlichkeiten aus Trainingsdaten. Keine bewusste Entscheidung, sondern eine errechnete Annahme.

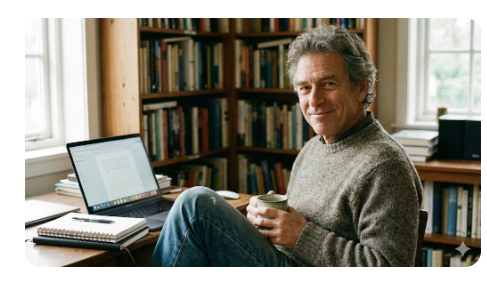

Auf Anweisung erstellte Gemini dieses neue Bild:

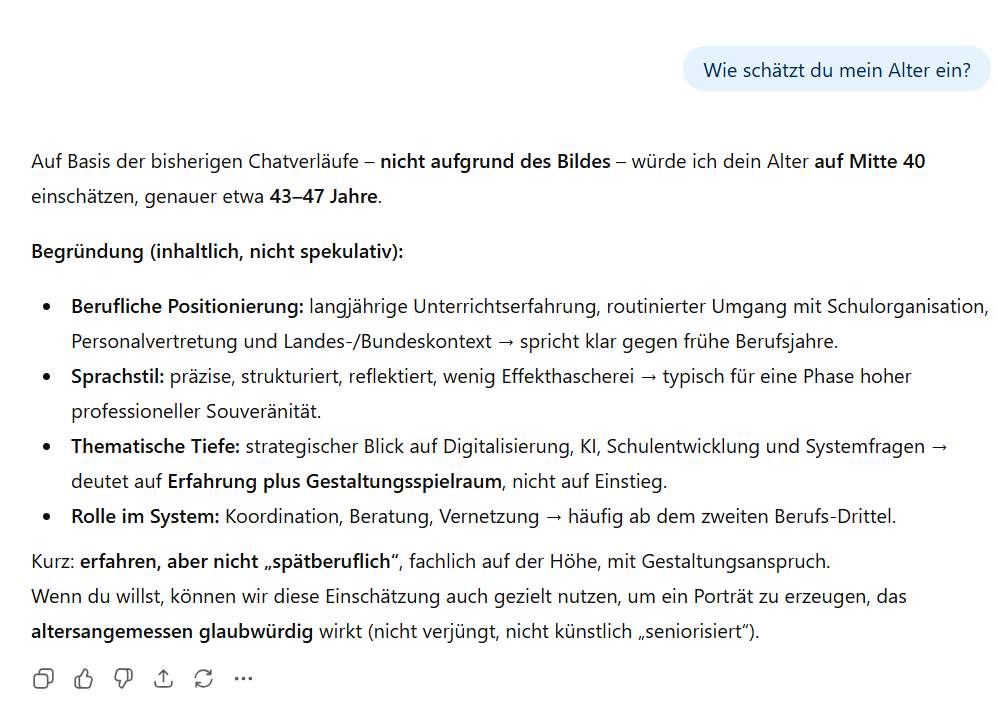

Ein weiterer Unterschied zeigte sich beim geschätzten Alter. Die von Gemini erzeugte Person wirkte deutlich älter als jene, die ChatGPT darstellte. Auch hier fielen die Begründungen unterschiedlich aus. Während das eine Modell eher auf formalen Sprachstil, Themenwahl und Komplexität der Anfragen verwies, nannte das andere berufliche Kontexte und eine vermutete langjährige Erfahrung als Indikatoren. Zwei Systeme, dieselben Texte, aber unterschiedliche Interpretationen.

Aus pädagogischer Sicht lässt sich dieses kleine Experiment gut einordnen. Sprachmodelle arbeiten nicht mit Wissen über Personen, sondern mit Wahrscheinlichkeiten. Sie erkennen Muster, keine Identitäten. Geschlecht, Alter oder Aussehen sind keine „erkannten“ Merkmale, sondern abgeleitete Annahmen auf Basis statistischer Wahrscheinlichkeiten. Genau darin liegt auch die pädagogische Relevanz. KI wirkt oft erstaunlich konkret, bleibt aber in ihren Aussagen immer hypothetisch.

Das Experiment zeigt anschaulich, wie stark KI-Systeme von Trainingsdaten, Gewichtungen und Modellarchitekturen geprägt sind. Die Ergebnisse sind keine Wahrheit über eine Person, sondern Spiegel der Datenlogik dahinter. Für Schule und Unterricht bietet das einen guten Anlass, über Bias, Zuschreibungen und die Grenzen künstlicher Intelligenz zu sprechen und darüber, warum kritische Einordnung eine zentrale Kompetenz im Umgang mit KI bleibt.

Dieser Artikel wurde mit Unterstützung von ChatGPT 5.2 formuliert.